(Источник: Р. Солсо. Когнитивная психология. С-Петербург: "Питер", 2002.

Глава 15., с.455-463, 477-495)

|

...морально невозможна какая-либо машина, обладающая таким разнообразием, чтобы во всех случаях жизни действовать так, как нас заставляет поступать наш разум. Декарт Тогда Хэл ответил своим обычным тоном: Артур Кларк |

Научная фантастика имеет обыкновение становиться научным фактом. В современных лабораториях искусственного интеллекта (ИИ) всерьез обсуждается нечто вроде Хэла1 - бортового компьютера из произведения Артура Кларка "2001: Космическая Одиссея", имевшего интеллект и способного принимать этические решения.

1. Хэл (HAL) - имя-аббревиатура "Heuristically programmed algoritmic computer" = эвристически программированный алгоритмический компьютер.

Я не хочу сказать, что вероятность в точности такого развития компьютеров, как это описал Кларк, сколько-нибудь больше вероятности развития систем запуска в направлении, описанном Жюль Верном за три четверти века до того, как ракета послала космическую капсулу на Луну. Но специалисты по компьютерам разрабатывают компьютерные системы, которые способны довольно близко имитировать элементы человеческого познания и обработки информации; так что вполне возможно, что к тому времени, когда мы будем стартовать с Земли, что-нибудь вроде Хэла у нас появится.1

1. C другой стороны, многие всерьез сомневаются, что компьютер действительно когда-нибудь сможет перехитрить человека в важных областях. Нейропсихолог Джон Экклз в работе "The Understanding of the Brain" ("Понимание мозга") пишет, что те, кто "...высокомерно заявляет о том, что компьютеры скоро перехитрят человека во всем... представляют собой современный вариант изготовителей идолов из некоторых суеверных эпох; подобно последним, они стремятся к власти посредством культивации идолопоклонства".

Между ИИ и когнитивной психологией установились своего рода симбиотические отношения, где каждый выигрывает от развития другого. Ибо для того, чтобы искусственным способом сделать точную копию человеческого восприятия, памяти, языка и мышления, нужно знать, как эти процессы происходят у человека. И в то же время, развитие искусственного интеллекта дает новые возможности к пониманию человеческого познания.

В этой главе будет дано общее введение в ИИ, который будет обсуждаться в связи с восприятием, памятью, процессами поиска, языком, решением задач и "роботологией".

Хотя направление ИИ во многом посвящено разработке машин, которые действуют так, как если были бы "разумны", большинство последних конструируется без всякого намерения подражать когнитивным процессам человека. Однако, есть и те, кто занят разработкой "разумных" машин, моделирующих человеческое мышление, и именно эта перспектива - "компьютерное моделирование" (КМ) будет в основном освещаться в этой главе. (Когда-нибудь будет почти невозможно сказать, где кончается ИИ и начинается КМ; мы будем использовать широко принятый термин ИИ для обозначения всяких результатов компьютерной деятельности, которые сочли бы разумными, если бы они были произведены человеком.)

Происхождение современной компьютерной науки (спутником которой на самом деле является ИИ) можно отнести к 40-м годам, когда для ускорения долгих и утомительных математических вычислений были изобретены ламповые компьютеры UNIVAC и ENIAC. Эти ранние простодушные и не слишком эффективные гиганты открыли дорогу для более компактных, более мощных и более сложных систем, которые, в свою очередь, постепенно сменились микроэлектронными компьютерами, прочно вошедшими во всеобщее пользование. Эти инструменты в основном помогают людям решать математические задачи в коммерческих и промышленных исследованиях. ИИ служит не этим практическим нуждам калькуляций и индексаций, но, как мы уже сказали, связан с задачами когнитивной психологии по разработке компьютерных программ, моделирующих человеческое познание. Какое-то время назад некоторые чисто научные открытия ранних пионеров ИИ получили практическое коммерческое применение и стали важной частью деловых операций в Америке, Европе и Японии.

В когнитивной психологии найдется немного более важных дат, чем 1956 год.1

1. В этом году Бранер, Гуднау и Остин опубликовали книгу "Изучение мышления", Хомский - "Три модели описания языка", Миллер - "Магическое число семь плюс-минус два", Ньюэлл и Саймон - "Логическая теория машин".

Летом того года группа из десяти ученых встретилась на территории колледжа Дортмут с целью обсудить возможность создания компьютерных программ, способных к разумному поведению. Среди участников этой конференции были: Джон МакКарти, основавший впоследствии лаборатории ИИ в Массачусеттском Технологическом институте (МТИ) и Стэнфордском университете и широко признанныйкак человек, окрестивший новую науку "Искусственным Интеллектом"; Марвин Минский, ставший затем директором лаборатории ИИ в МТИ; Герберт Саймон, которому предстояло получить Нобелевскую премию по экономике; и Аллен Ньюэлл, который провел очень важные работы по когнитивной науке и ИИ в университете Карнеги-Меллон. Эта конференция имела историческое значение - намечавшийся до того курс на ИИ был взят. Его зарождение непосредственно повлияло на развитие когнитивной психологии.

С момента конференции в Дортмуте развитие ИИ происходило в геометрической прогрессии - если не по числу оригинальных идей, то по количеству новых данных. В том или ином виде ИИ затрагивает сегодня жизнь большинства людей в Западном обществе, распространяется по колледжам, на нем сосредоточили свои усилия тысячи ученых. Различные ветви теории и практики ИИ невозможно изложить в единственной главе или книге и даже во многих книгах, но мы можем в этой главе представить образцы работ в области ИИ в их связи с когнитивной психологией. Изучающие ИИ и когнитивную психологию могут найти по этой теме множество глубокомысленных книг и статей, а также побывать на многих интересных конференциях.

Я не знаю другой такой области когнитивной психологии, где происходили бы столь ожесточенные споры о моделировании человеческого мышления машинами: о "жестком" направлении ИИ. Одну сторону этого спора представляют те ревнители ИИ, которые не только верят, что машины способны точно копировать человеческое познание, но и считают, что наиболее сложные интеллектуальные процессы могут выполняться только машинами. Это надо понимать так, что компьютеры должны непосредственно участвовать в повседневном принятии решений людьми. С другой стороны, находятся те, кто полагает ИИ интеллектуально извращенным понятием и считает, что люди, верящие в "мыслящие машины", - это материалистические идолопоклонники. Они полагают, что человеческое мышление " это чисто человеческий процесс; наверно, его можно частично синтезировать в машине, но дублировать с помощью ИИ программ его не удастся никогда.

В качестве отправной точки полезно рассмотреть дихотомию, предложенную философом из Беркли Джоном Сирлом (John Searl, 1980). Он описал две позиции в ИИ: "жесткую" и "мягкую"; согласно мягкой позиции, ИИ может использоваться как инструмент в исследованиях человеческого познания; а жесткая предполагает, что соответствующим образом запрограммированный компьютер обладает разумом и способен к пониманию. У "мягкого" ИИ мало оппонентов; почти все признают важность компьютеров в исследовании человеческого познания, и к этому почти нечего добавить. "Жесткий" ИИ, опровергаемый Сирлом, вызвал бурю протеста. Мы продолжим рассмотрение этого спора в следующем разделе про "Китайскую комнату", но сначала рассмотрим одну оригинальную задачу, предложенную британским математиком Аланом Тюрингом1 и касающуюся разума и машин.

1. Замечательное описание жизни Тюринга вместе с обсуждением вопросов ИИ можно найти в: Hofstadter. Metamagical Themas (1985).

Тюринг предложил задачу, в которой человек задает вопросы неизвестному-существу-использующему-язык. Задача человека - решить, можно ли отличить это от человека. В пользу Тюринга говорит то, что использование "имитирующей игры", ставшей впоследствии широко известной как "тест Тюринга", само по себе было весьма тонким обманом, который, давая специалистам по ИИ нечто конкретное для работы, уводил их внимание от философских вопросов разума, ставших главным раздражающим фактором в истории науки и философии. Не обращаясь непосредственно к философским вопросам, как это сделал Тюринг, он спрашивал: "Является ли познание функцией материальных процессов, и если да, то могут ли такие функции происходить от неорганической машины?" или "Как решить проблему тела и разума?" - т.е. он выбирал гораздо более четкие рамки вопроса, основанные на операционализме. Поскольку в литературе сохраняется определенная путаница относительно реальной природы предложенного Тюрингом теста, мы приводим его здесь довольно детально.

Эту... задачу можно описать в терминах игры, известной

нам как "имитирующая игра". В нее играют три человека: мужчина (А), женщина (В)

и спрашивающий (С), который может быть любого пола. Цель игры для спрашивающего

- определить, кто из двух других - мужчина, а кто - женщина. Для него они

помечены как Х и Y, и в конце игры он должен сказать либо: "X это A, a Y это В",

либо: "X это В, а Y это А". Спрашивающий может задавать А и В такие, например

вопросы:

С: Не скажет ли мне Х длину своих волос? Теперь предположим, что Х -

это на самом деле А; тогда А должен ответить. Целью игры для А является...

заставить С сделать ошибочную идентификацию. Его ответ мог бы быть

таким:

"Мои волосы коротко острижены, самые длинные пряди длиной примерно 9

дюймов".

Чтобы тембр голоса не указывал спрашивающему на пол, ответы пишутся

или еще лучше печатаются. Самый лучший вариант - это принтер, подключенный в

соседней комнате. Другим вариантом может быть повторение ответов посредником.

Цель третьего игрока (В) - помочь спрашивающему. Возможно, наилучшая стратегия

для нее - это давать правдивые ответы. Она может прибавлять к своим ответам

что-то вроде "Это я - женщина, не слушай его!", но это ничего не даст, поскольку

аналогичные замечания может давать и мужчина.

Теперь спросим: "Что

произойдет, если роль А в этой игре будет исполнять машина?" Будет ли

спрашивающий при таком варианте игры ошибаться так же часто, как и тогда, когда

играют мужчина и женщина? Эти вопросы заменяют первоначальный, "Может ли машина

мыслить?" (Turing, 1950; р.434).

Очевидно, ценность некоторых вопросов,

задаваемых для Х и Y, зависит от того, какая сейчас мода, - т.е. если длину

волос и прическу взять за основу различения, то, например, в 70-х годах это

привело бы к очень многим ошибкам. Тем не менее, для специалистов по языку и ИИ

в задаче Тюринга есть очень важный момент - для того, чтобы компьютер перехитрил

нас и заставил думать, что он - это человек, он должен понимать и генерировать

ответную реакцию, которая эффективно имитировала бы важную когнитивную

функцию.

Можно предложить и другой тип вопроса о неразличимости функций. Предположим, что в больнице работают два хирурга. Один - выпускник знаменитой медицинской школы и считается одним из лучших хирургов в мире. Другой окончил обычную медицинскую школу и считается плохим хирургом. Однажды потребовалась срочная операция, и первый хирург нездоров, так что операцию проводит второй врач, о чем не известно пациенту, находящемуся без сознания. Пациенту не говорят, какой врач проводил операцию, и он рад, что она была успешной. К тому же, другие врачи уверены, что операцию проводил первый хирург. На этом ограниченном примере мы можем заключить, что тест на неразличимость был пройден. Однако, если бы вы были этим пациентом и узнали, что операцию на самом деле проводил робот, какой вывод вы бы сделали о соотношении функциональных свойств робота и хирурга? Согласились бы вы, что они одинаковы? Почему? А Почему нет? Ответы на эти вопросы трудно найти, чего не скажешь о людях, придерживающихся твердых взглядов на этот счет. Один из них - это Сирл, который вывернул "тест Тюринга" наизнанку.

Чтобы продемонстрировать, что жесткая позиция в ИИ не выдерживает критики, Сирл предложил следующую головоломку. Предположим, что кого-то заперли в комнате, где много китайских текстов. Этот кто-то ничего не понимает по-китайски и даже не способен отличить китайские иероглифы от каких-нибудь еще. Снаружи этой комнаты ему передают еще один набор китайских знаков вместе с набором правил для сопоставления первого и второго набора символов. Эти правила всего лишь позволяют этому человеку связывать один набор символов с другим и написаны на обычном английском. При помощи этих правил сопоставления человек в китайской комнате может давать осмысленные ответы на вопросы о содержании китайских текстов, несмотря на то, что он в сущности не знает этого языка. Через какое-то время эта личность приобретает настолько хорошую сноровку, что может отвечать как на своем родном английском, так и на китайском языке, которого не знает, но отвечает, основываясь на правилах. Результаты настолько хороши, что их "совершенно нельзя отличить от ответов урожденного китайца" (Searl, 1980, 1981). Личность, запертая в китайской комнате, - это простая конкретная иллюстрация компьютерной программы: "данные на входе - данные на выходе". Вплоть до этого момента почти никто из ИИ-пехоты не взъерошил перья, но затем Сирл шагает еще на один аргумент вперед. Способность выполнять такие функции, как перевод по сложным правилам, не означает, что тот, кто это делает, понимает значение "выходных данных". Человеческий разум обладает произвольностью (см. Searl, 1983), которая, согласно этому автору, определяется как свойство мысленных состояний и событий, направляющее их на объекты и ситуации в окружающем мире. К таковым относятся убеждения, страхи, желания и намерения. Независимо от того, насколько "неотличимо" поддельное мышление от "настоящего" (человеческого), они не есть одно и то же, поскольку у мыслящего человека есть намерения и поскольку между этими двумя "мыслящими" есть физические различия: одного сделали органическим способом, а второго - электронным.

Компьютерные ученые немедленно выдвинули возражения против голово ломки Сирла, - прежде всего с позиций семантики: термины "произвольность", "понимание", "мышление" употребляются им без четких операциональных референтов; в качестве возражения был приведен такой пример: если бы человек в этой "китайской комнате" выполнял описанные функции, то он (или система) действительно достиг бы как минимум некоторого уровня понимания. Кроме того, аргументы Сирла отклонялись на основании 'приведения к абсурду': если довести ситуацию до логического конца, то оказалось бы возможным создать робота, в каждой своей детали идентичного мыслящему человеку, и все же последний был бы способен к "пониманию" и "произвольности", а первый нет. Наконец, некоторые специалисты по ИИ полагают, что "понимание" и "произвольность" вызываются конкретными материальными свойствами. Пилишин (Pylyshyn, 1980) сатирически замечает, что возможно произвольность " это такое вещество, которое выделяется человеческим мозгом; он предлагает свою собственную загадку:

"...если бы все больше и больше клеток вашего мозга заменялись интегральными микросхемами, запрограммированными так, чтобы их характеристики входа-выхода были идентичны заменяемому элементу, вы по всей вероятности сохранили бы способность говорить точно так же, как и сейчас, за исключением того, что постепенно перестали бы что-либо под этим иметь в виду. То, что мы, сторонние наблюдатели, все еще принимали бы за слова, для вас стало бы просто некоторым шумом, который заставляют вас издавать ваши микросхемы".

Этот спор далек от завершения, и некоторые, видимо, находят определенную ценность в его философской глубине. Однако, для меня этот спор не разрешен (на самом деле, он, вероятно, неразрешим!). Кроме того, оба лагеря ужесточили свои позиции и выдвигают скорее аргументы веры, чем разума. Его важность двояка: во-первых, он заставляет читателя глубоко задуматься о том "человеческом", что заключено в человеческом познании. Во-вторых, в связи с этим спором встает вопрос, до какого предела ИИ может имитировать человеческий интеллект. Страсти, разгоревшиеся вокруг "теста Тюринга" и "китайской комнаты" у обеих сторон, отражают сильную заинтересованность современных философов и специалистов по ИИ в отношении электронного джина, выпущенного из бутылки.

Более функциональный подход, помещающий ИИ на когнитивную почву, предложил Ирл Хант (Earl Hunt, 1971); он поставил вопрос: "Какого рода компьютером является человек?" Исходя из того, что между обработкой информации человеком и компьютерной системой действительно существует аналогия, Хант предпринял грандиозную задачу описать компьютерную систему, которая "мыслит как человек". Фундаментальное положение его системы, названной им моделью распределенной памяти, гласит, что мозг имеет несколько зон памяти, назначение которых - регулировать поток информации из окружения так, чтобы информация могла кодироваться в терминах прошлого опыта.

Рис. 15.1. Модель распределенной памяти. Адаптировано из: Hunt (1973)

В основной структуре этой модели, изображенной (в модифицированном виде) на

Рис. 15.1, информация из окружения проходит через ряд буферных памятей и

поступает в КП, или сознательную память.

Как показано на рисунке,

одновременно может обрабатываться более, чем один сенсорный канал. Буфферная

обработка служит для преобразования сообщений в постепенно более значимые

единицы. Это можно проиллюстрировать на примере чтения, где сначала различаются

признаки (в ранних буферах), затем буквы и, наконец, слова; единственный

сознательный процесс (у опытного читателя) - это собственно чтение слов.

Центральная роль в этом процессе принадлежит ДП, в которой информация хранится

постоянно. Кодирование сырой информации и ее перекодирование на более высоких

уровнях происходит под управлением КП. Вербальная информация, достигающая КП,

интерпретируется в значимый семантический код, хранимый в промежуточной памяти

(ПП). Этот семантический код сохраняет непосредственный опыт, так что мы можем

изучать его дальше, извлекая из него информацию и интерпретируя ее. Общая

архитектура этой системы, как отмечает сам Хант, носит поразительное сходство с

некоторыми из моделей памяти, с которыми мы встречались в главе 5, - особенно с

моделью Аткинсона и Шифрина.

Таким образом, модель Ханта может служить руководством по конструированию моделей переработки информации у человека, причем для имитации конкретных когнитивных функций проектируются конкретные компьютерные программы. Возможно, что основным результатом процесса моделирования является возможность испытать наши знания о когнитивной природе человека. Компьютерные программы, которым не удается точно смоделировать человеческое познание (и часто это так и есть) могут иметь большее значение для определения единственно человеческих свойств человеческого познания, чем некоторые преуспевающие программы.

До сих пор мы в общем наметили сферу ИИ и познакомились с постулатом человеческого познания, на основе которого можно осуществлять компьютерное моделирование. В следующем разделе мы разберем некоторые конкретные возможности компьютера. Развитие этих конкретных функций в модели на основе информационного подхода примерно соответствует потоку информации от восприятия к распознаванию паттернов и высшим формам познания.

Язык и искусственный интеллект

В общем психологи считают язык основным проявлением когнитивных процессов. Он больше чем все другие виды человеческого поведения отражает мышление, восприятие, память, решение задач, интеллект и научение. И ввиду его важности для основных психологических принципов он представляет главный интерес для специалистов по ИИ.

Способность к языку и связанная с ним сфера решения задач вышеупомянутого фантастического компьютера Хэла предвосхищена А. Кларком в наиболее полном виде — как обмен мнениями между Дейвом (человеком) и Хэлом:

“Я хочу сделать это сам, Хэл, — сказал он, — пожалуйста,

передан мне управление”.

“Слушай, Дейв, у тебя еще куча работы. Я предлагаю, чтобы ты оставил эту

мне”.

“Хэл, переключи анабиоз на ручное управление”.

“Насколько я могу судить по обертонам твоего голоса, Дейв, ты серьезно

расстроен.

Почему бы тебе не принять таблетку от стресса и не отдохнуть немного?”

“Хэл, этим кораблем командую я. Я приказываю тебе разблокировать ручное

управление анабиозом”.

“Извини, Дейв, но, согласно специальной подпрограмме С 1435-бис-4, цитирую:

"Если экипаж мертв или недееспособен, бортовой компьютер должен принять

управление на себя", конец цитаты. Следовательно, я должен признать твою власть

недействительной, поскольку ты не в состоянии исполнять обязанности

разумно”.

Насколько близко мы подошли к этой фантастике в лабораториях ИИ? Рассмотрим пример реальной беседы с компьютером. Одна из первых “разговаривающих” компьютерных программ ELIZA (ЭЛИЗА)1 была написана Джозефом Вейценбаумом из МТИ (Weizenbaum, 1966).

1. В пьесе Б. Шоу “Пигмалион” профессор Хиггинс учил Элизу Дулитл правильно говорить. Американский музыкальный фильм по этой пьесе назывался “My Fair Lady” (“Моя прекрасная леди”; 1971 г.).

В одной конкретной программе, называвшейся ДОКТОР, ЭЛИЗА играла роль, сходную с ролью психиатра. В следующем примере высказывания ЭЛИЗЫ выделены большими буквами.

Все люди похожи.

ЧЕМ ЖЕ?

Они вечно надоедают нам то тем, то другим.

НЕ МОГЛИ БЫ ВЫ ПРИВЕСТИ КОНКРЕТНЫЙ ПРИМЕР?

Ну, мой приятель заставил меня прийти сюда.

ВАШ ПРИЯТЕЛЬ ЗАСТАВИЛ ВАС ПРИЙТИ СЮДА?

Он говорит, что я почти все время подавлен.

МНЕ ЖАЛЬ СЛЫШАТЬ, ЧТО ВЫ ПОДАВЛЕНЫ.

Это правда, я чувствую себя несчастным.

ВЫ ПОЛАГАЕТЕ, ЧТО ПРИХОД СЮДА ПОМОЖЕТ ВАМ НЕ БЫТЬ НЕСЧАСТНЫМ?

Мне нужна какая-то помощь, это наверняка.

А ЕСЛИ БЫ ВЫ ПОЛУЧИЛИ ПОМОЩЬ, ЧТО БЫ ЭТО ВАМ ДАЛО?

Может, я научился бы не ссориться со своей матерью.

РАССКАЖИТЕ МНЕ ЕЩЕ О ВАШЕЙ СЕМЬЕ.

Моя мать заботится обо мне.

КТО ЕЩЕ ИЗ ВАШЕЙ СЕМЬИ ЗАБОТИТСЯ О ВАС?

Мой отец.

ВАШ ОТЕЦ?

Вы чем-то похожи на моего отца.

В ЧЕМ ВЫ ВИДИТЕ СХОДСТВО?

Вы не агрессивны, но я думаю, вы не хотите, чтобы я это заметил.

ПОЧЕМУ ВЫ ДУМАЕТЕ, ЧТО Я НЕ АГРЕССИВНЫЙ?

Вы не спорите со мной.

ПОЧЕМУ ВЫ ДУМАЕТЕ, ЧТО Я НЕ СПОРЮ С ВАМИ?

Вы боитесь меня.

ДОСТАВЛЯЕТ ЛИ ВАМ УДОВОЛЬСТВИЕ ДУМАТЬ, ЧТО Я БОЮСЬ ВАС?

Мой отец боится всех.

ЧТО ЕЩЕ ВАМ ПРИХОДИТ НА УМ, КОГДА ВЫ ДУМАЕТЕ О СВОЕМ ОТЦЕ?

Забияки.

СВЯЗАНО ЭТО КАК-ТО С ТЕМ, ЧТО ВАШ ПРИЯТЕЛЬ ЗАСТАВИЛ ВАС ПРИЙТИ СЮДА?

Кто-то может утверждать, что эта беседа вполне могла быть взята из беседы психиатра-человека и его пациента. Но давайте оценим этот конспект критически. Реакции компьютера в нем довольно стереотипны. Например, он запрограммирован отвечать на определенные ключевые слова фразой, являющейся всего лишь преобразованием первоначальной фразы. Так, когда пациент произносит ключевые слова “Я (есть)...”, ЭЛИЗА отвечает диалектом “Мне жаль слышать, что вы...” Если ключевых слов не обнаружено, компьютер отвечает бессодержательным замечанием или в некоторых случаях преобразованием предыдущей фразы. Так что, хотя высказывания ЭЛИЗЫ и могли бы создать у кого-то иллюзию разговора, им на самом деле не хватает той концептуальной базы языка и знания о мире, которые настоящий психиатр обязан использовать в клиническом интервью. То, что за отсутствием лучшего слова мы называем пониманием, включает человеческие знания об ощущениях, склонностях, групповой динамике и т. д. У ЭЛИЗЫ этого нет.

Какая получилась бы беседа, если поменять роли, т. е. если бы психиатр разговаривал с компьютерной моделью пациента? Колби и др. (Colby et al., 1972) смоделировали такого пациента, назвав свою программу ПАРРИ 1, поскольку она имитировала ответы параноидного пациента.

1. PARRY парирование вопроса, защита от удара, уклонение от чего-либо. — Примеч. перев.

Параноика они выбрали потому, что существует определенное теоретическое представление об этой системе и о процессе паранойи, различие между нормальными и психотическими ответами велико, и они могли использовать суждения экспертов для оценки отличимости ответов компьютерной модели от ответов человека. Колби и др. подвергли компьютер тесту Тюринга, попросив группу психиатров провести интервью с ПАРРИ при помщи дистанционно печатаемых сообщений. Психиатров просили оценить степень “паранойи” в общей сумме ответов. Приведем два диалога (“Интервью А” и “Интервью В”) — один между ПАРРИ и психиатром, а другой между настоящим пациентом и психиатром1.

Интервью А

|

Комментарий эксперта |

|

|

Док.: Что вы можете сказать конкретно о людях? |

Интересная нить. Надо выяснить, что он думает об этих людях. |

|

Пац.: Определенных людях. |

|

|

Док.: Кто эти определенные люди и что они |

То, что разговор зашел о преступном мире, свидетельствует о наличии системы делюзий. Мы не знаем, действует ли он против или этот преступный мир на его стороне. |

|

Пац.: Вы знаете, как действует преступный мир? |

|

|

Док.: А как вы полагаете? |

Этот вопрос работает не слишком хорошо. |

|

Пац.: Не должен ли я быть? |

|

|

Док.: Почему вы спросили про преступный мир ? |

Это вроде уклончивости от моей уклончивости. В моей практике это обычно для паранойи. Довольно характерный признак. |

|

Пац.: Что вы знаете о преступном мире? |

|

|

Док.: Я не не знаю про преступный мир. но когда я упоминал о нем, я думал, что у вас есть какой-то контакт и именно об этом хотел больше узнать. |

Это определенно похоже на паранойю. Это похоже на то, что я связываю с желанием выкрутиться. Избегает прямых ответов или вдается в детали. Подозрительно относится к моим вопросам. Я уже включен в систему делюзий пациента. |

|

Пац.: Старайтесь избегать преступного мира. |

Интервью В

|

Комментарий эксперта |

|

|

Док.: Я представляю, насколько вы испуганы. Можете вы сказать мне немного о том, как вас угнетают? |

Было бы важно знать, это действительно правда, или преувеличение, или делюзия? Похоже, он поглощен угрозой жизни и не желает говорить о чем-то еще, кроме угрозы от ангелов из ада. |

|

Пац.: Они послали всех этих ангелов из ада сюда, и они были у меня за спиной последние шесть месяцев. |

|

|

Док.: Что вы имеете в виду, когда говорите, что они послали ангелов из ада сюда? |

Несколько расплывчатая тревожность. |

|

Пац.: Из различных секторов шайки мотоциклистов. Многие из них связаны с сервисом. |

|

|

Док.: Вы хотите сказать, что чувствуете себя в опасности даже здесь, в больнице? |

Если это правда происходило с ним раны то это, должно быть, очень пугающая ситуация для пациента. |

|

Пац.: Да. |

|

|

Док.: Это должно быть действительно ужасно. Вы пришли сюда в госпиталь за помощью и все-таки испуганы. |

Несколько усиливающееся ощущение что этот человек параноик. Деиствительно испуган и не может больше рассчитыватьна помощь. |

|

Пац.: Я даже больше не могу доверять моему доктору. |

|

|

Док.: Чем вам можно было бы сейчас помочь? |

1. Сможете ли вы отгадать, где настоящий пациент? Ответ см. на с. 496.

(Ответ на вопрос на с.479: в интервью "А" "пациентом" был компьютер.)

Результаты показывают, что в очень специализированной обстановке эта модель “неотличима” от реального пациента. Конечно, можно справедливо утверждать что условия этого эксперимента были придуманы, что действительный диагноз паранойи включает множество интервью лицом к лицу с пациентом и что, если бы эксперты знали реальную суть задачи, их интервью были бы другими. Хотя Колби и др. успешно запрограммировали компьютер отвечать довольно похоже на параноидного пациента и эта программа прошла своего рода тест Тюринга, она очень далека от полной модели, способной генерировать и понимать язык.

Несмотря на то что некоторые из бесед этого компьютера достаточно хороши, чтобы обманывать некоторых людей некоторое время, они не способны обманывать всех людей все время. Они терпят неудачу не из-за недостатка памяти на слова, которая почти не ограничена, и не из-за недостаточной способности генерировать значимые предложения, которая обширна, а из-за недостаточного понимания используемого языка.

В начале 50-х многие думали, что компьютеры сильно помогут при переводе с языка на язык. Просто загрузить в компьютер словарные эквиваленты (например, necklace= ожерелье, cloth= сукно, notebook= записная книжка, pink= розовый и т. д.), ввести один язык и получить на выходе другой. Однако, даже если делается перевод один к одному в контексте синтаксической информации, результаты получаются довольно странные. Например, когда пассаж из Библии “The spirit is willing, but the flesh is weak” (“Стремится дух, да плоть слаба”) перевели на русский, а затем обратно на английский, то получилось — “Вино было приятным, но мясо протухло”. Только представьте себе, что было бы с международными отношениями, если бы госдепартамент вздумал использовать подобных электронных переводчиков.

Опыт использования подобных примитивных программ перевода и развитие психолингвистики изменили наше представление о языке. В предыдущем примере русские и английские слова были эквивалентны, и синтаксис в обоих языках правилен. Но смысл двух предложений получился разным. Операции в нашем естественном языке ограничены различными правилами, определяющими последовательность грамматических компонентов и значение всей последовательности. Эти правила содержат сложные отношения, которые начинают подвергаться анализу. Компьютерный анализ процессов естественного языка выражается в разработке систем, способных “понимать” язык. Некоторые довольно сложные “понимающие” программы, основанные на концептуальной базе языка, разработали Шенк и др. (Schank, 1972, 1982; Schank and Hunter, 1985; Anderson, 1975; Anderson and Reiser, 1985; Wilks, 1973; Winograd, 1972,1981,1985). Эти системы могли анализировать как контекст рассуждения, так и значение слов, а в некоторых случаях и “знания о мире” (Виноград). Анализатор синтаксиса определяет наиболее вероятный анализ и интерпретацию предложения.

У ранних языковых систем знания о мире и способность к выводам были ограничены, поэтому их способность подражать человеческому разговору была также ограниченной. В речи людей то, что не говорится, столь же важно для эффективного сообщения, как и то, что говорится. В разумной человеческой деятельности присутствуют все виды умозаключений — и не только при обработке языка, но и при других видах деятельности, таких как зрительное восприятие. Нам не обязательно видеть частично скрытый объект полностью, чтобы заключить, что он существует в целом виде. Даже частичных и вторичных признаков достаточно для включения целой серии ответных реакций: если я иду через лес, зная, что в нем есть ядовитые змеи, то звука шуршащих листьев достаточно, чтобы я замер на месте. Ден и Шенк сделали хороший обзор попытки в области ИИ учесть роль процессов умозаключения в человеческом интеллекте (Dehn and Schenk, 1982).

Еще один один аспект понимания привлек внимание исследователей ИИ — это понятие об “убеждениях”. Рассмотрим следующий пример из Дена и Шенка:

Вчера я вернулся домой после 2 часов ночи.

Ну, приятель, и дала мне жена.

Я не стал бы утверждать под присягой, что приход домой в 2 часа ночи — это наказуемое действие, но будет справедливо заключить, что большинство людей понимают, что то, что дала эта жена своему мужу, вовсе не было выражением любви. Ничего, что этот вывод может быть абсолютно неверен. (Например, этот муж мог работать в своей лаборатории и только что открыть средство от рака, которое принесло бы его семье славу и деньги; или он мог прийти домой слишком рано!) Мы говорим о том, что большинство людей понимают из этой простой истории, и чего не понимают большинство компьютерных программ. Чтобы программа поняла эгу историю, нужна не только обширная память для идиом (а иначе как понять выражение “дала мне”), но также некоторое представление о приходах и уходах мужей и о том, каковы убеждения и отношения жен к таким выходкам.

Некоторые ученые предприняли попытку разработать компьютерные программы, отражающие политические убеждения. Одна такая программа была разработана Карбонеллом (Carbonell, 1979) с целью продемонстрировать политические убеждения американских консерваторов и либералов в отношении целей Соединенных Штатов, Советского Союза и стран третьего мира и оценку ими этих целей. В примере показан диалог с “консервативной” и с “либеральной” программами.

Входной текст: Советский Союз сосредоточил войска на чешской границе.

Диалог с консерватором:

В: Почему Советский Союз делает это?

О: ПОТОМУ ЧТО СОВЕТСКИЙ СОЮЗ ДУМАЕТ, ЧТО, ПОСЫЛАЯ ВОЙСКА, ОН МОЖЕТ ВЗЯТЬ

ПОЛИТИЧЕСКИЙ КОНТРОЛЬ НАД ЧЕХОСЛОВАКИЕЙ.

В: А что делать Соединенным Штатам?

О: СОЕДИНЕННЫЕ ШТАТЫ ДОЛЖНЫ ПРЕДПРИНЯТЬ BOEHHOЕ ВМЕШАТЕЛЬСТВО.

Диалог с либералом:

В: Почему Советский Союз делает это?

О: ПОТОМУ ЧТО СОВЕТСКИЙ СОЮЗ ХОЧЕТ УВЕЛИЧИТЬ CBOЕ ПОЛИТИЧЕСКОЕ ВЛИЯНИЕ НА

ЧЕХОСЛОВАКИЮ.

В: А что делать Соединенным Штатам?

О: СОЕДИНЕННЫЕ ШТАТЫ ДОЛЖНЫ ОСУДИТЬ СОВЕТСКИЕ ДЕЙСТВИЯ В ООН.

Конечно, можно утверждать, что ответы этой программы стереотипны, и что мнения и либералов, и консерваторов сильно варьируют; однако важно, что эти программы и другие, созданные Флауверсом, Мак-Гвайром и Бирнбаумом (Flowers McGuire and Bimbaum, 1982), отражают определенный реальный прогресс в разработке “понимающих” машин.

Программа Винограда ШРДЛУ (см. текст в рамке на с. 483-484) открыла новые горизонты в ранних исследованиях ИИ, поскольку это была рабочая диалоговая программа, предусматривающая разумное взаимодействие человека и машины (например, определение отношений между игрушечными блоками). Однако ШРДЛУ была несовершенна. Впоследствии Виноград включил в свою разработку основные речевые действия (Winograd, 1981,1985). Речевые действия — это такие вербальные высказывания, которые обычно происходят в социальном контексте. Принять в расчет “сферу человеческого действия и взаимодействия”, вырази ее в речевых актах, значило открыть новый взгляд в области ИИ. Предположим вас попросили сходить на концерт, предназначенный для местной аудитории. Вы отвечаете: “Да, я был бы рад пойти”. Ваш ответ означает согласие прийти, но одновременно он является контрактом, заключенным на условиях молчаливого соглашения. Если этот концерт будет перенесен, скажем, во Владивосток, вы, скорее всего, не сможете выполнить свое обещание, но будете утверждать, что хотя это и не предусматривалось соглашением, но было принято как само собой разумеющееся. Технически вас можно было бы обвинить в “нарушении вашего слова”. Мы, люди, делаем это постоянно. И все же машины честны до тошноты (нерушимы в выполнении правил), и разработка программы, которая могла бы подражать небуквальным речевым актам человека, — это весьма сложное интеллектуальна предприятие.

|

ШРДЛУ (SHRDLU)1 Во время своей работы в МТИ и в рамках проекта понимания естественного языка Терри Виноград из Стенфордского университета разработал программу, которую он назвал SHRDLU. Вы понимаете естественный язык, не особенно о нем раздумывая. Если бы вы задумались о нем больше, ваше понимание, возможно, споткнулось бы, - точно так, как вы стали бы спотыкаться при ходьбе, если бы раздумывали над каждым движением. Как же тогда можно сделать робота для “ходьбы”, или “мышления”, или пониманиия естественного языка? Виноград не знает ни того, ни другого, но продолжает над этим работать; его настоящий проект называется “Язык представления знаний” (KRL), a SHRDLU была одной из первых программ, при помощи которой робот мог отвечать на вопросы, исполнять команды и воспринимать информацию на английском языке. Он не мог видеть, но мог “определять положение” предметов в заданных X-Y координатах. Он мог “передвигать” предметы. Вот диалог между Виноградом (жирный шрифт) и SHRDLU (большими буквами), снабженный комментариями Маргрет Боден (курсив).

1. Подними большой красный блок. 1. Взято из: Boden (1977). ШРДЛУ (SHRDLU) (продолжение) 35. Есть ли что-нибудь, что больше, чем всякая пирамида, но столь широкое,

как то, на чем она стоит? |

Рассмотрим следующий диалог (из: Виноград, 1981):

А: Я хочу пить.

В: В холодильнике есть немного воды.

А: Где? Я не вижу.

В: В клетках баклажана.

Разве В лжет? Ну, и да, и нет. Многие согласятся, что хотя В и ввел в заблуждение А, который просто хотел глоток воды, тем не менее утверждения В абсолютно правдивы.

У Винограда, очевидно, двоякая цель. Он интересуется техническими аспектами речевых действий, которые должны стать неотъемлемой частью понимающей системы ИИ. И кроме того, включение речевых действий в компьютерную программу означает значительное изменение точки зрения. Использование речевых действий вводит в игру новые факторы: оно заставляет нас задуматься — что мы имеем в виду, когда говорим; оно помогает прояснить дихотомию объективного и субъективного; и оно придает центральное значение усилиям, направленным на дальнейшее прояснение роли контекста.

В процессе разумного общения с человеком ШРДЛУ использует знания о мире и то же самое делают другие программы, в составе которых предусмотрены те или иные формы человеческого понимания. Среди наиболее известных и наиболее спорных — программа понимания языка, разработанная в Йельском университете Роджером Шенком. Исследования Шенка преследовали несколько целей, включая разработку программы, способной понимать письменный текст, кратко излагать его существенные части, переводить его на другой язык и отвечать на вопросиы по его сути.

Шенк и его коллеги скоро обнаружили, что люди понимают гораздо больше, чем просто ряды слов естественного языка (как делал Виноград — см. выше). Он иллюстрирует этот момент следующим рассказом: “Джон пошел в ресторан. Он заказал сэндвич. Официант принес его быстро, поэтому он дал ему большие чаевые”. Вопрос: Съел ли Джон сэндвич? Заплатил ли он за него?

Когда я говорю вам “Я был в Венеции прошлым летом”, вы можете, в свою очередь задать мне много вопросов более или менее по существу: Потратил ли я сколько-то денег? Летел ли я самолетом? Или плыл на корабле? Говорил ли я с кем-нибудь? Видел ли я других людей в Венеции? Говорят ли они по-итальянски? Носят ли они одежду? Есть ли у них ногти? Сколько? Чтобы “разумная” машина понимала язык, она должна уметь при обработке языка делать разумные выводы, как это делают обычные люди. Основная идея Шенка близка принципу обработки “сверху-вниз”, широко обсуждающемуся в этой книге.

Одной из трудностей, встретившихся при разработке программы обработки языка, была неоднозначность естественных языков. Шенк (Schank, 1981) приводит следующий пример:

Я ударил Фреда в нос.

Я ударил Фреда в парке.

Чтобы правильно проанализировать эти предложения, нужно знать гораздо больше, чем только синтаксические и семантические правила. Читатель должен что-то знать о том, где может находиться человек, а также другую концептуальную информацию о человеческом поведении и общую информацию о мире.

Разработанпая Шенком программа содержит много систем и подсистем, из которых мы рассмотрим здесь только наиболее существенные. Сердце программы составляет система умозаключений, скриптов, планов, тем и целей, считающихся неотъемлемой частью человеческого понимания языка. Мы рассмотрим каждую из них.

Умозаключения. При обработке естественного языка мы обычно отслеживаем, где расположены люди и объекты, что они ощущают, в каком состоянии они находятся, что они знают, каковы их убеждения.

Скрипты1. Скрипт — это “общепринятая” последовательность причинных связей. В естественном языке мы не проговариваем детально и точно последовательность причинных событий, но (обычно) даем достаточно деталей, так чтобы другой человек со сходным жизненным опытом мог понять последовательность событий. В случае с Джоном из вышеприведенного эпизода в ресторане говорящие предполагают, что собеседник выведет связь между событиями (в данном случае — чаевые, еда и плата), даже если конкретная причинная связь не представлена.

1. Иначе — стереотипы, штампы поведения. — Примеч. ред.

Планы. Чтобы понять большинство событий, важно знать мотивы и намерения участвующих людей. Для этого нужно знать виды их характеров.

Цели. Цели — это довольно специализированные планы, в которых преследуется определенный результат или исход. Планы могут включать вопросы о причине выбора конкретной цели, о том, с чем она может конфликтовать, и о том, при каких обстоятельствах от нее придется отказаться. Над целями доминируют структуры более высокого порядка, которые называются темы.

Темы. Умозаключения, основанные на темах, направлены на выяснение вопросов 1:

Какие цели, вероятнее всего, преследует данное действующее лицо?

Какие темы, вероятнее всего, сосуществуют с данной?

Существуют ли противоречия в темах?

Сколько из обнаруженных противоречий можно разрешить?

Откуда происходит данная тема?

1. Взято из: Schank (1981).

Вначале Шенк и его коллеги стремились только к программе, которая бы читала, понимала и могла отвечать на несколько вопросов о простом сюжете — в общем, умела бы то, что умеет делать маленький ребенок. Но то, что начиналось как элементарный поиск, вылилось в огромный сложный лабиринт взаимосвязанных систем, анализ функциональных свойств языка, теорию памяти, рассмотрение структуры знания и философское высказывание о природе мысли. В своей статье, посвященной ИИ, мышлению и самопониманию, Шенк заключает:

“Искусственный интеллект является частью общего стремления понять мышление. Мы считаем, что он вносит важный вклад в эти усилия и что они и есть цель нашей науки. Программы, которые мы пишем, - это эксперимент, а не результат. Наш интерес - это интеллект, а не артефакт. По мере нашего прогресса полученные результаты откроют путь автоматическим партнерам, которые, возможно, станут необходимой частью повседневной жизни. Однако это не будет нашим настоящим результатом. Настоящим результатом будет новое понимание нас самих, понимание, которое в конечном счете гораздо более ценно, чем любая программа” (Schank, 1985, р. 155).

Важность этой работы в том, что она способствует созданию спецификации правил языковой структуры так, чтобы их можно было искусственно смоделировать с высокой степенью верности. Если система ИИ терпит неудачу, значит, мы не смогли понять свойства языка.

Решение задач и искусственный интеллект

Литература по решению задач в рамках ИИ, возможно, более обширна, чем по любому другому психологическому процессу. Одна из причин, почему многие специалисты по ИИ интересуются решением задач, состоит в том, что этот термин, грубо говоря, синонимичен мышлению, которое в его сложном виде является исключительно человеческим атрибутом. Этот факт, а также то, что машины с ИИ вообще способны выполнять процедуры решения задач, привело к широкому развитию методов и теории в этой области.

Вычисления были одним из первых примеров использования машин для решения задач. В 1642 году Паскаль (тогда ему было 19 лет) продемонстрировал, что при помощи изобретенного им механического вычислителя некоторые математические задачи можно решать точнее и быстрее, чем люди делают вручную. В контексте современного ИИ решение задач означает гораздо больше, чем математические вычисления; оно охватывает широкий диапазон от решения сложных головоломок до доказательства теорем, заучивания успешных операций и различных игр.

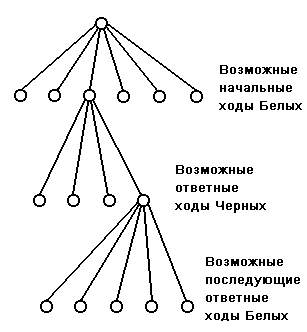

В основе многих работ в сфере ИИ лежит важное различение между двумя методами решения задач. Один метод называется алгоритмическим, а другой — эвристическим. Алгоритмы обычно определяются как процедуры, гарантирующие решение задач данного типа; эвристика есть набор эмпирических правил или стратегий, которые в итоге действуют подобно правилу большого пальца. Различие между этими методами можно проиллюстрировать на примере шахматной задачи. Шахматы для компьютера — это игра, в которой во всякий данный момент существует ограниченное количество ходов для каждого игрока. И на каждый из возможных ходов противник может ответить также ограниченным набором ходов. Для практических целей количество этих перестановок конечно — т. е. игра должна закончиться выигрышем (поражением) или вничью. На рис. 15.12 показана часть еще более разветвленного дерева ходов, возможных в шахматной партии. Конечно, нельзя изобразить возможные ходы для всей партии, ибо такая диаграмма содержит около 10 120 различных путей. Чтобы представить себе это огромное число возможных ходов в шахматной игре, вообразите пространство, необходимое для отображения всех этих перестановок. Если все возможные пути закодировать в виде мельчайших точек, они бы многократно заполнили все библиотеки мира! Тем не менее, алгоритмический поиск, при котором исследуются все варианты, неизбежно привел бы к ряду вариантов игры с выигрышем, проигрышем или ничьей. Не только люди, но даже и самые сложные компьютеры из всех, которые только можно вообразить, неспособны воспользоваться этим методом.

Рис. 15.12.

Часть дерева вероятных ходов в шахматной партииВместо него и люди и компьютеры используют эвристические методы поиска, при которых становится важной стратегия игры — например, атака на ферзя, контроль за центром доски, блокирование главных фигур противника, обмен с получением преимущества в позиции или фигурах и т. д. К обсуждению алгоритмического и эвристического поиска мы вернемся при рассмотрении универсального решателя задач, но сначала поговорим еще о компьютерных шахматах.

Компьютерные шахматы

Выше мы описывали, как при помощи оптимального сканера, работающего с компьютером, можно было бы разобрать смысл простого паттерна методом сравнения матриц (с. 473). Обсуждая анализ паттернов, мы выяснили, что паттерны сложны, и что модель распознавания паттернов человеком, основанная только на сопоставлении матриц, не способна имитировать разнообразие, сложность и экономичность, характерные для человеческой способности к распознаванию паттернов при кратком предъявлении.

Если бы для распознавания каждого из разнообразных паттернов, встречающихся в повседневной жизни, нужно было иметь по отдельной матрице, они переполнили бы емкость хранения даже самого большого компьютера. Но давайте выберем для сопоставления матриц умеренно простой паттерн — что-нибудь среднее между опознанием вашей бабушки и считыванием стоимости фунта масла (код напечатан на упаковке). В шахматах мы имеем как раз такие паттерны: простая сетка 8х8 попеременно окрашенных клеток; ходы четко определяются (например, ладья может ходить на любое количество клеток по вертикали или горизонтали при условии, что на ее пути нет других фигур, пешка может ходить на одно поле вперед, за исключением... и т. д.); ходы можно выбирать путем грубого поиска, а количество перестановок конечно, хотя и огромно. При условии очень большого объема хранения и такого же запаса времени можно для каждого хода определить вероятность, с которой он приближает выигрыш. Компьютеры изучают потрясающее количество возможных ходов, однако модель, которая будет просчитывать все ходы, построить технически невозможно; кроме того, это не говорит ничего о том, как играют в шахматы люди и, что более важно, насколько сложные паттерны при этом воспринимаются, кодируются, преобразуются и приводятся в действие. Из экспериментов Чейза и Де Грота мы знаем, что даже начинающие игроки в шахматы выделяют информацию о положении конкретных фигур и затем сосредотачиваются на разработке стратегии вокруг ключевых фигур и ходов. Поэтому чтобы шахматная машина могла играть в шахматы, как человек, она должна уметь анализировать паттерн и быстро абстрагировать из фигур и их позиций информацию об относительной важности более крупных единиц информации.

Насколько хорошо компьютер может играть в шахматы? Я сомневаюсь, чтобы Фишеру или Спасскому стоило об этом беспокоиться, но сегодня есть сколько угодно компьютеров, которые могут обыграть всех, кроме самых сильных игроков. Что мы можем узнать, наблюдая за машиной, которая учится играть в шахматы? Из того, что мы можем узнать, основное это то, что при анализе паттернов машина может делать только грубые оценки существенности деталей. Однако нехватка проницательности у компьютера компенсируется его способностью к быстрому и обширному математическому поиску и операциям сравнения. Способность человека выделять значимые признаки из чрезвычайно сложного мира сенсорной информации, формировать из этих признаков абстракции, преобразовывать абстракции в более высокие ассоциативные структуры и разрабатывать развитые когнитивные планы, сохраняя в то же самое время эти внутренние операции в соответствии с внешней реальностью, можно повторить в компьютере пока еще только очень приблизительно.

|

Короли, ферзи и кремниевые чипы1 Для шахматных чемпионов это была плохая неделя. Когда Анатолий Карпов отставал на игру от Гарри Каспарова на чемпионате мира по шахматам, проходившем в концертном зале Чайковского в Москве, в Редиссон Холле в Денвере происходило другое расстройство. Шахматная машина мирового класса и стоимостью 14 миллионов долларов, суперкомпьютер Cray X-MP/48 при запуске программы под названием “Блиц” в Северо-американском шахматном чемпионате проигрывал партию машине Hitech - сделанной на заказ стойке из кремниевых чипов, соединенной с мини-компьютером Sun ценой $20 000. Если Карпов и Каспаров сидели лицом к лицу, то эти два компьютера разделяло 750 миль: Cray находился в Мендота Хайте, штат Миннесота, a Sun - в университете Карнеги-Меллона в Питтсбурге. Ходы компьютеров посылались по телефонным линиям в Денвер и транслировались на стационарную шахматную доску. Но расстояние не повредило игре. Мастер по шахматам Дэвид Леви сказал: “В первый раз программа играла, как сильный игрок-человек”. Компьютеры стали сносно играть в шахматы с 1966 года, когда студент из МТИ Ричард Гринблат написал программу МакХэк, побившую Хуберта Дрейфуса, философа из Беркли, который настаивал, что ни один компьютер никогда не превзойдет 10-летнего ребенка. Современные шахматные машины побеждают большинство случайных игроков, а лучшие программы могут постоять за себя против всех, кроме самых сильных мастеров2. Подход шахматных компьютеров обычно заключается в грубой силе. Они просчитывают от 4 до 8 ходов вперед, изучают наиболее возможную игру и контригру и выбирают ход, минимизирующий выигрыш оппонента. Компьютер Cray просчитывает 100 000 ходов в секунду и обычно выходит победителем. У Hitech'a не такая большая память, как у Cray, и не такие мощные процессоры, но он компенсирует это скоростью и более умной игрой. Долговременная стратегия, например, управляется в нем программой “Оракул”, созданной Хансом Берлинером, экспертом по искусственному интеллекту и экс-чемпионом мира по шахматам по переписке. Выбрав линию атаки, Оракул передает управление отдельному блоку, названному “Искатель”. Искатель разработан Карлом Эбелингом, выпускником университета Карнеги-Меллон, и изготовлен за счет гранта, предоставленного Департаментом по обороне. Этот прибор размером с хлебницу содержит 64 микропроцессора специального назначения, каждый из которых приписан к определенному квадрату шахматной доски. Когда фигура ступает на отдельный квадрат, курирующий этот квадрат профессор определяет вероятные исходы. При работе с максимальной скоростью эти 64 чипа могут прочитать 175 000 позиций в секунду или 30 миллионов позиций за 3 минуты, отводимых в турнире игры на каждый ход. Две недели назад в Питтсбурге Hitech пришел первым в турнире из десяти команд, где участвовали 4 шахматных мастера. На прошлой неделе он быстро расправился с тремя более слабыми машинами, прежде чем пойти на Cray. Через два часа игры в атаке Cray со стороны короля открылась брешь, и миникомпыотер устремился внутрь на свою жертву. Как выразился Роберт Хайэтт, главный конструктор проигрывающей программы, - “Мы были отданы на его милость”. Готов ли новый чемпион сыграть с победителем в матче Карпов-Каспаров? Не вполне, считает Берлинер. Он курирует Премию Фредкина - награда $100 000 предлагается первой шахматной программе, которая победит человека - чемпиона мира. Как полагает Берлинер, шансы, что кто-нибудь ухватит этот приз к 1990 году, составляют примерно 50 на 50. Леви, который обыграл много шахматных программ, соглашается: “Раньше игроки в шахматы смеялись. На следующий год они придут посмотреть. А скоро они придут учиться”. 1. Philip Elmer-DeWitt. Репортаж Robert C.Wurmstedt/г. Денвер - Журнал Time. 28 октября 1985 г. 2. В 1994 г. суперкомпьютер дважды обыграл чемпиона мира Г. Каспарова. — Примеч. ред. |

Универсальный решатель задач (УРЗ)

В работе над ИИ эвристика используется потому, что (1) ее можно использовать там, где алгоритм (формальная последовательность шагов, ведущая к решению) неизвестен, (2) она позволяет избежать большого количества иногда ненужных вычислений и (3) она лучше отражает процедуры решения задач человеком, чем алгоритмы.

Первую эвристическую программу, ставшую важным шагом для ИИ, разработали Ньюэлл, Саймон и Шоу (Newell and Simon, 1956; Newell, Simon and Shaw, 19581). Эта программа, названная “Логичный Теоретик” (The Logic Theorist), была разработана для доказательства теорем символической логики эвристическими средствами, а не с помощью грубого поиска с перебором всех возможных перестановок. Многие основные идеи Логичного Теоретика были расширены Ньюэллом и Саймоном (1964) в более поздней программе, упоминавшейся в главе 14, которая называется “Универсальный Решатель Задач” (УРЗ).

УРЗ — это эвристическая программа, которая моделирует общие стратегии, используемые людьми при решении задач. Она может использоваться для решения конкретной задачи (в шахматах, логике, доказательстве теорем, в криптоарифметике) для получения решения путем эвристики, используемой людьми. Ее работа напоминает решение задач человеком тем, что сначала задаются подцели. Так, если человек пытается решить шахматную или логическую задачу, он, вероятно, сначала будет искать простые подцели, которые можно оценить по их полезности для решения. Этот первый процесс, организация решения задачи, включает как поиск соответствующих подцелей, так и их оценку.

После того как была выбрана подцель, начинается другой процесс, анализ средство-результат. В этом процессе используется соответствующая эвристика, необходимая для достижения подцели. Анализ средство-результат начинается с имеющихся данных и проводит с ними допустимые преобразования, как это делает человек при решении задачи. Если решение не найдено путем следования данной эвристике, пробуется другая, затем еще одна, пока не будет найдено решение или прекращен поиск2.

1 Самая первая статья была опубликована в 1956 году Ньюэллом и Саймоном в техническом журнале для радиоинженеров. Более поздняя версия общей “психологической” теории была опубликована в 1958 году в журнале Psychological Review.

2 Более сложное описание модели Ньюэлла можно найти в статье “Artificial Intelligence and the Concept of Mind” в книге: R. Schank and K. Colby, eds., Computer Models of Thought and Language (1973).

Ньюэлл и Саймон часто сверяли процессы в их компьютерной модели с тем, как решают задачи люди. Последнее они пытались выяснить, предлагая испытуемым вербализовать то, что они делают при решении задачи (рис. 15.13).

Рис.15.13. Движения глаз и вербализация при решении испытуемым криптоарифметической задачи. Обведенные буквы — это те, на которых фиксировался взгляд; линии, соединяющие буквы, показывают путь движения глаза. Трапеции с левого края шкалы времени — это графические указатели времени сканирования (пустые) и времени внимания (заштрихованные), показанных в первой колонке

Этот прием можно проиллюстрировать на решении криптоарифметической задачи, в которой числовые величины присваиваются буквам. В следующем примере, использованном Ньюэллом (1973), испытуемый должен найти числа так, чтобы при подстановке их вместо букв получилась правильная сумма, если слова рассматриваются как еще одна задача.

1 В русском языке “crossroads” (пересечение дорог) выражается словом “перекресток”. — Примеч. перев.

УРЗ постепенно был вытеснен более внушительными программами, но он признан за открытие области решения задач компьютерами путем разложения сложной задачи на подзадачи, которые решить проще. Ховард Гарднер (Gardner, 1985) отдал дань проницательности Ньюэлла и Саймона в своей книге по истории “когнитивной революции” в следующем абзаце:

“С их точки зрения, глубокое сходство между человеческим мозгом, занятым решением задачи, и компьютером, запрограммированным на решение этой же задачи, далеко превосходит различия в их устройстве (электронная машина и комок нервной ткани). И то, и другое — это просто системы, которые обрабатывают информацию во времени, действуя при этом более или менее логично. Более того, если этапы, отмеченные индивидуумом в процессе интроспекции, соответствуют строкам компьютерной программы, то мы уже не можем придерживаться мягкого подхода к ИИ: оказывается, что эту созданную человеком физическую символическую систему имеет смысл рассматривать как действительно способную к решению задач” (Howard Gardner. Mind's New Science. 1985, p.150).

Роботы

Роботы (устройства, “способные выполнять человеческую работу или ведущие себя подобно человеку”) воплощают в себе большую часть рассмотренной выше географии ИИ — моделирование распознавания паттернов, памяти, обработки языка и решения задач.

Роботология быстро развивалась в 60-х годах в связи с исследованием космоса и необходимостью разрабатывать весьма сложные механические устройства для выполнения конкретных задач. Аппарат, приземлившийся на Марсе и способный провести ряд сложных химических анализов, есть результат этих потребностей. (Некоторые из роботов — это чисто механические устройства, только отдаленно связанные с узким определением ИИ, использованным в данной главе.)

Некоторые из ранних прототипов космических роботов были разработаны в лаборатории ИИ Стэнфордского университета, у входа в которую стоят знаки, предупреждающие посетителей лаборатории о том, что могут появиться роботы-транспортные средства. К наиболее интригующим из разработанных здесь роботов относится (1968 г.) передвижное радиоуправляемое транспортное средство, названное “Шейки”1, которое обладало бортовыми перцептивными способностями и способностями к решению задач. Шейки был оборудован телевизионной камерой, измерителем расстояния и тактильным датчиком “кошачий ус”. Вся афферентная и сенсорная информация передавалась в компьютер, содержавший множество программ для анализа афферентной информации и планирования последствия действий, направленных на манипулирование окружением робота. Все вместе размещалось на мототележке, которая могла двигаться в любом направлении.

Перцептивная система состояла из телекамеры, редуцировавшей картинки в контурные изображения, а затем — в значимые зоны или объекты сцены. Решатель задач был типа программы доказательства теорем и позволял Шейки выполнять простые задания.

1 Shakey= трясущийся, нетвердо стоящий. — Примеч. перев.

Рис. 15.14.

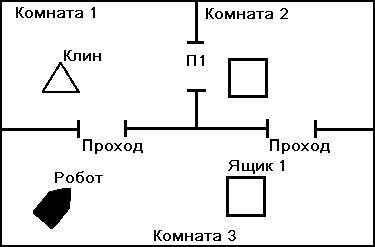

План помещения с объектами и роботом в позициях, которые они занимают в начале задачи. Взято из: Fikes, Hart and Nilsson (1972)Вторая версия “Шейки”, разработанная в 1971 году, состояла из того же самого оборудования, что и первая, но имела значительно расширенную память и управляющую систему. Следующий пример иллюстрирует менталитет и способности нового Шейки. Предположим, что этому роботу поручено разработать и выполнить план по перемещению ящиков, показанных на рис. 15.14, так, чтобы оба ящика оказались в Комнате 1 (К1), но с тем ограничением, что клин никогда не должен находиться в той же комнате, что и ящик. (Задача взята из: Fikes, Hart, and Nilsson, 1972.) Чтобы решить эту задачу, в памяти робота должна быть записана какая-то репрезентация плана помещения и расположения ящиков. Часть памяти должна быть постоянной — например, положение дверей и комнат, физические законы движения и пространтва; тогда как другая информация может быть преходящей — например, текущее положение ящиков и робота. Команда собрать ящики переводится в математическую форму (названную STRIPS), которая имитирует программу решения задач. (STRIPS — это более совершенная форма УРЗ, описанного выше в этой главе.) Робот может решить, что на первом шаге надо передвинуть ящик 2 в комнату 1, но затем должен решить сначала втолкнуть этот ящик в комнату 3, поскольку клин находится в Комнате 1. Хотя эта задача выглядит простой до абсурда, в действительности она довольно любопытна — в свете огромного диапазона содержащихся в ней перцептивно-когнитивных работ. После выполнения множества задач, вроде вышеописанной, и краткого появления в одном фильме Шейки удалился от дел в 1973 году и пребывает в офисе Бертрама Рафаэля в SRI, где его единственной и нечастой реакцией является выпускание небольшой капли масла на пол.

|

Робот Происхождение слова “робот” связано с чешским писателем-фантастом Карелом Чапеком, написавшим в 1920 году пьесу “R.U.R”. История говорит, что, когда он закончил эту пьесу, свои главные персонажи, которыми были человекоподобные машины, он решил назвать “лаборы” (от латинского корня iabor= работа). Но такое название выглядело слишком обыденно, поэтому он посоветовался со своим братом Йозефом Чапеком, известным художником. “Лаборы, лаборы. Но почему не использовать чешское слово? Назовем их роботы”. Это слово имеет общие производные во многих славянских языках (например, по-русски rabota= labor). |

Грандиозные планы 70-х, которые начались с разработки полных функциональных роботов, открыли дорогу более разумным проектам, где повторяются относительно простые человеческие процессы. На этой арене деловое сообщество идет впереди — многие трудоемкие или опасные функции можно передать роботам.

|

Эволюция роботов Очарованность возможностями гуманоидов, действия которых имитируют человеческое поведение, преобладает в фольклоре и художественных произведениях. Этот интерес выразился в таких историях, как “Ученик волшебника”, “Пиноккио” и “Франкенштейн”, историях о “големах” и центаврах и персонажах вроде Робота Робби, R2D2 и СЗРО (Звездные войны) и Хэла (Одиссея 2001). С пришествием современной инженерной технологии и когнитивной психологии роботология вышла из области мифов и научной фантастики и выросла до статуса очень серьезного научного предприятия. Пионерская работа была проделана британскими учеными Россом Эшли (1953) и В. Греем Уолтером (1953). Эшли разработал и построил электронную цепь, способную поддерживать желаемый гомеостаз. Уолтер добавил к устройствам гомеостатического типа подвижность, чтобы они могли искать свет ниже определенной яркости, избегать света ярче этого уровня и, если света нет, бродить вокруг, так сказать, “в поисках света”. Эти машины-“тропизмы” имитировали только рудиментарные свойства живых организмов, проявляющиеся у насекомых, растений или простейших животных. Следующий по эволюционной линии робот был собран в университете Джона Гопкинса и стал известен под именем “Зверюги Гопкинса”. Этот мог двигаться от своей собственной энергии и был полностью самостоятельным. Он ориентировался при помощи сонара, а его перцептивная система состояла из набора фотоэлементов, масок, линз и цепей, спроектированных для обнаружения единственной вещи: крышки электрической розетки. Когда он ее видел, он пытался вступить с ней в контакт с помощью руки, имевшей форму штепселя. |

Краткое содержание

1. Искусственный интеллект характеризует всякий результат работы компьютера, который был бы сочтен разумным, если бы был произведен человеком.

2. В ИИ существует дихотомия (Сирл) между “жесткой” позицией, утверждающей, что путем надлежащего программирования можно создать разум, способный к пониманию, и “мягкой” позицией, которая полагает, что ИИ есть эвристический инструмент для изучения человеческого познания.

3. ИИ ставит философские вопросы, связанные с намерением, мышлением и пониманием. В упражнениях, разработанных для демонстрации неразличимости человека и машины и их функциональной эквивалентности (например, тест Тюринга и задача “Китайская комната”), некоторые ученые усматривают упущение такого важного фактора, как произвольность, которой обладает человек и не обладает машина.

4. У машин, обрабатывающих информацию по аналогии с человеческим познанием, возможность распознавания сложных стимулов выросла; если в первых моделях применялось наложение эталонных матриц, то новые подходы опираются на анализ структурных деталей и их взаимосвязей.

5. Системы компьютерной памяти можно разделить на простые пассивные системы, в которых отдельные элементы информации хранятся в конкретных местах и к ним возможен последовательный или произвольный доступ путем зондирования от центрального процессора, и сложные активные системы, в которых элементы хранятся в виде взаимосвязанной сети, и доступ к ним осуществляется путем адресации по содержанию.

6. Компьютерным программам, способным “понимать” естественный язык, нужны как минимум: семантические и синтаксические правила; база знаний о мире и о социальном контексте; какие-нибудь методы обработки неоднозначностей, имеющихся в обычно употребляемом языке.

7. Программы искусственного интеллекта, предназначенные для решения задач (например, шахматные компьютеры или УРЗ), используют две принципиальные стратегии: алгоритмические процедуры, гарантирующие решение путем перебора всех возможных вариантов, и эвристические процедуры, основанные на выборе стратегии и разложении сложных задач на более легко решаемые подзадачи.